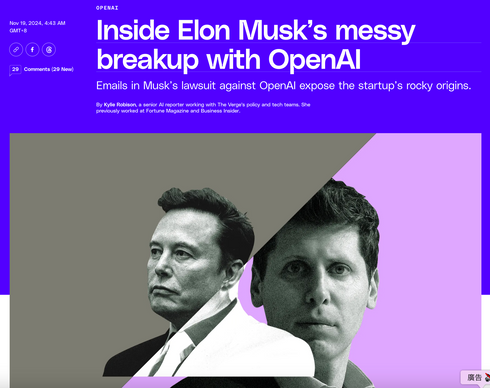

電影《異星入境》的原作、科幻短篇小說集《你一生的故事》的作者 Ted Chiang(姜峯楠)在 The New Yorker 發表一篇文章〈ChatGPT 是網路上的一個模糊 JPEG文件〉。文章的最後,談到了「大型語言模型(LLM,Large Language Model)是否可能成為原創作品的起點?」

我對於這個問題很感興趣,而我的答案是在短期內不大可能。Ted Chiang 是從一個比較感性與詩意的角度思考,但我認爲不可能的原因,和 Ted Chiang 不太相同。

原因一:道德限制器

第一個原因在〈「為什麼美國有 ChatGPT 而中國沒有?」AI 競賽成為新冷戰的戰場〉有提到過,也就是目前語言模型都會加上限制器,以免 AI 亂回答搞出公關危機。

這樣的限制器,使得目前的 LLM(Large Language Model)很適合寫文案、做資料整理,卻非常不適合創作。如果你要 ChatGPT 寫一首詩或一篇散文,他只會給你一段勵志心靈雞湯。這並非 AI 創意能力的問題,而是因為當代文學與影視作品的審美,往往講求挖掘深層、黑暗的人性,而這些往往會被視為「不道德的」。(比如,讓 AI 生成一個謀殺故事,大概會令社會大眾毛骨悚然。)

不過,限制器應該是相對好解決的。如果能準確定義產品為「文學寫作助手」,拆掉限制器可能不會造成問題。然而,GPT 在技術本身,還有不利於創作的地方。

原因二:GPT-3.5 原理限制

第二個原因則是 GPT 模型的技術本質。

ChatGPT 背後的模型 GPT-3.5,原理是給出「機率最大的下一個字」。也就是,在當下文字脈絡下,不斷產生最「合理」的字。

然而,如果總是講最安全的意見,也就會是最普通的意見。這會是一個善於迎合語境的聊天者,卻不會有太原創的想法。

正因為 ChatGPT 永遠有辦法跟人尬聊下去,所以很適合用來當作語言練習的對象——他永遠不會詞窮,即使講的內容超級無聊。更棒的一點是:他不是真人,不用怕丟臉。

然而,要拿來創作,就不太合用了。

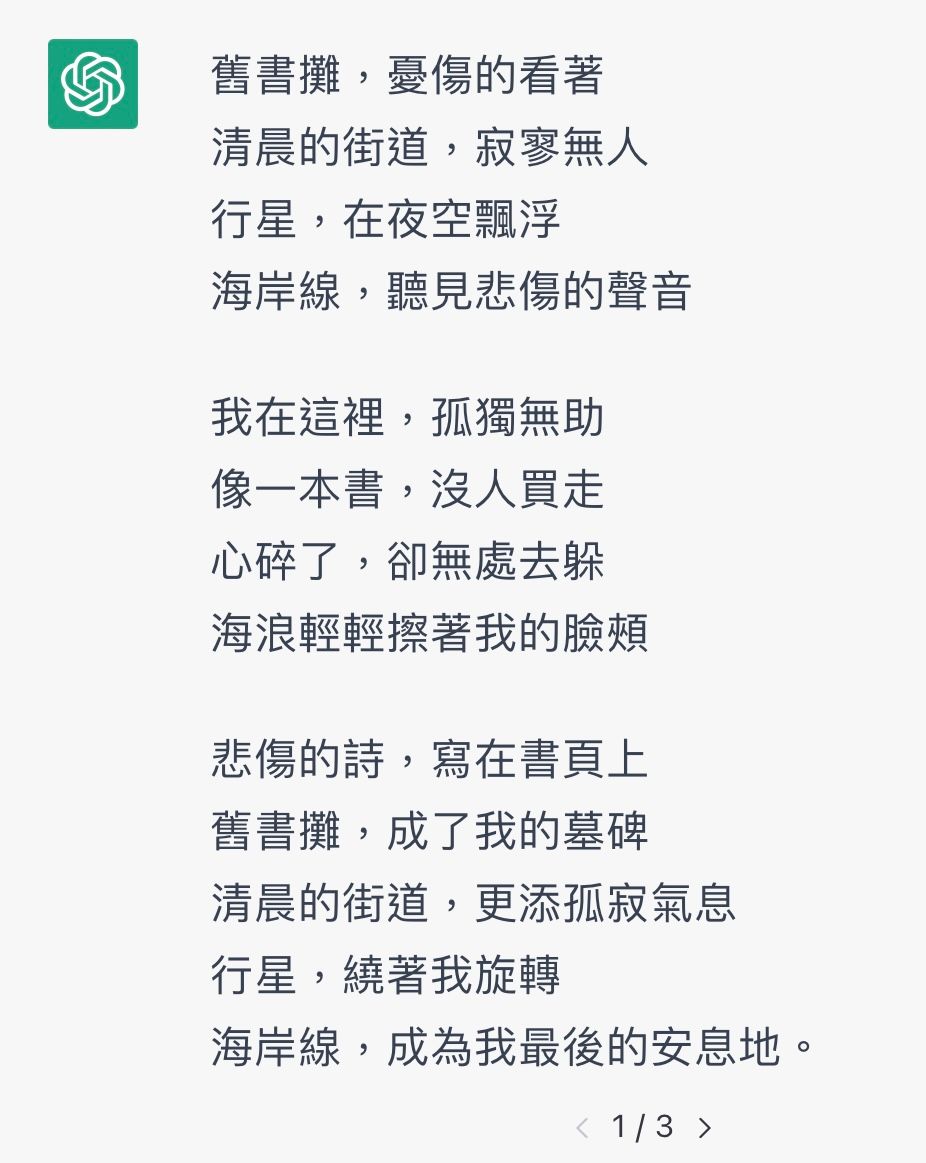

在 2022 年底 ChatGPT 出來之後,我就已經嘗試過用它來寫詩。我的實驗心得是,要他模仿誰的風格,或是指定行數都是沒有用的。我實驗出來,能產出稍好句子的做法,是直接指定要用幾個完全不相干的詞彙來寫詩。例如:用「舊書攤」、「清晨的街道」、「行星」和「海岸線」寫一首詩。

結果算是差強人意,但更重要的是,這樣其實等於是我在寫,不是 ChatGPT 在寫。因為詩之所以能給人奇特的美感體驗,正是因為這些不相干的字眼,被依照某種看似有邏輯的方法組合起來。

就如同 Ted Chiang 將 GPT 模型比喻為 JPEG。以文學的角度,這比喻相當聰明,但從技術層面可說是相當離譜,且無助於大眾理解 AI。LLM 和 JPEG 在技術原理上幾乎沒有共通之處,然而文學上的比喻,正是追求這種「意料之外,卻竟然說得通」的巧思。

這也就帶到我認為 LLM 短期內無法進行文學創作的第三個原因。

原因三:GPT-3.5 無法「規劃」和「選擇」

任職於 Meta、同時也是 AI 大老 / 圖靈獎得主 / NYU 教授 的 Yann LeCun,認為現行 GPT 的一大限制是「無法規劃」。什麼是規劃?就是預先想出好幾種不同的可能性,並且預判未來的發展,再從中挑選最好的。

如果觀察人腦的運作,會發現我們無時無刻都在做這件事。「午餐要吃什麼?」我們會想像吃牛肉麵、咖喱飯或是雞腿便當的感覺,接著判斷自己當下最想吃哪一種食物。

文學更是高度依賴這類規劃決策。創作時,通常我們會很快想到一、兩種可能的思路。此時,最佳的策略,是強迫自己想出第三種,因為前面兩種都太過直覺了。這並不只適用於小眾的純文學,《進擊的巨人》之所以被封為神作,正是因為你永遠猜不到諫山創接下來到底會殺死哪個角色。

原創性是給出合理,但意料之外的發展。而人類並非總是依賴隨機的「靈感」創作,否則就會像更早期的語言 AI 一樣,講出完全不合邏輯的句子。人腦其實是想出好幾種普通的選項,接著再要求自己想出不普通的選項,從中挑選最「適合」的那個。

現在的 GPT 模型,只能給出最普通的那個選項,而且在把答案生成完之前,就連 GPT 自己也不知道自己會講出什麼話。因為根本沒有辦法預判,自然也就沒有挑選的機會。

也因此,LeCun 說,更好的模型將會出現。或許屆時,懂得規劃的 LLM 就有機會協助人們創作了。

番外:為什麼我不再用「生成式 AI」這個詞?

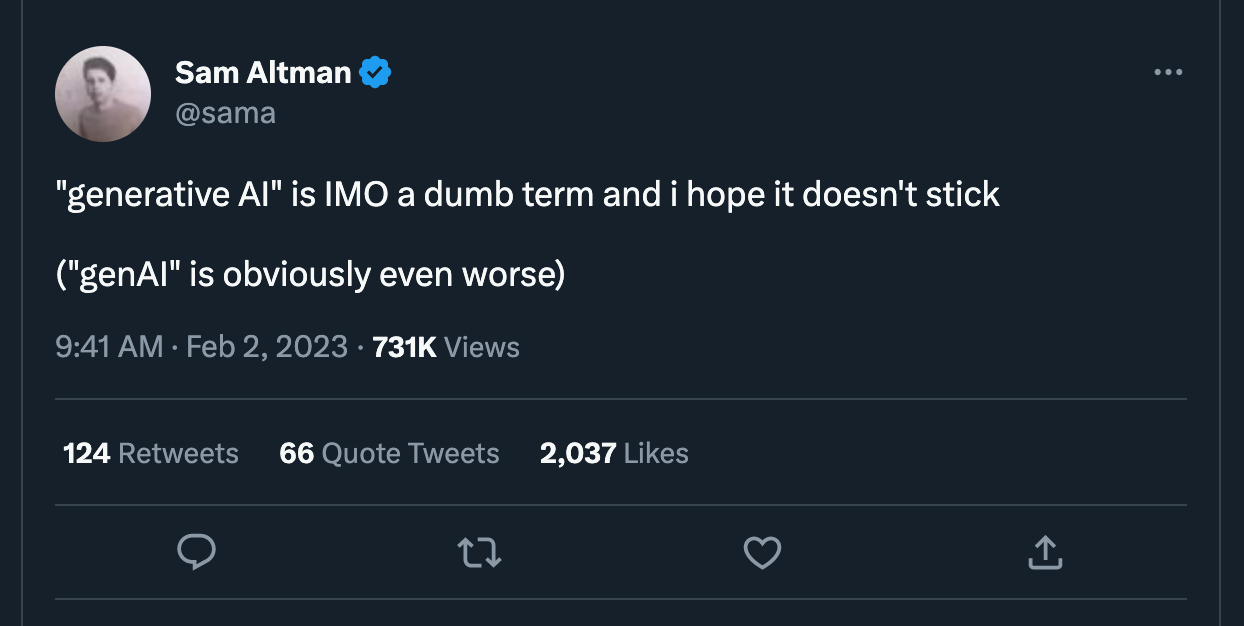

Open AI 的 CEO Sam Altman 前幾週發了一個推:Generative AI 是一個很蠢的詞。經過思考,我認為他說得很對。將 ChatGPT 這類大型語言模型,和 Midjourney 這類 Diffusion Model 歸為同一類,是完全錯誤的。

GPT 是不斷給你「機率最大的下一個字」,而 Diffusion Model 則是從 noise 一次一次「還原」成一張圖片(請原諒我過度簡化原理)。Midjourney 更是透過 UX 設計,把上述「規劃」和「決策」的過程交給了使用者:你可以透過點 U 或 V 來多次嘗試、生成新的圖片。

我不再使用「生成式 AI」這個詞,因為這樣的分類似乎沒有意義,不同模型間也沒有關聯。

也因此,我不太會怪吳淡如分不出 AI 繪圖和電腦繪圖(這次事件的問題核心恐怕更多是公關和情緒)。畢竟,我也曾經分不好這些 AI 模型,而全部用「生成式 AI」混為一談。

然而事件裡更有趣的是,吳淡如使用了「學習」這個字眼。就如同「怎麼 Google」也是需要「學習」的,這意味著現在的 AI 繪圖產品,都還不夠好到讓人直接上手。AI 的產品體驗還有非常多可發揮的空間,也必定會誕生非常多新創,這令我非常興奮。